Картинки и образы помогут найти смысл в интернете

В Сети каждый год появляются около 100 миллиардов изображений. Цифра внушительная, и, дабы хоть как-то с ней совладать, нужно совершенствовать критерии поиска. Работа в этом направлении сейчас активизировалась, и кое-какие увлекательные результаты смогут поменять отечественное отношение не только к визуальным, но и к простым текстовым запросам.

Обычный подход к «графической» проблеме выглядит достаточно легко. В том смысле, что ведущие поисковые машины, как, к примеру, Гугл с его совокупностью PageRank, надеются прежде всего на прекрасно известную методику оценки релевантности контекста.

По большей части разбирают содержание интернет-страницы, где расположен тот либо другой объект. Другими словами если вы на своём сайте поместили сочинение на тему «Как я совершил отпуск на Багамах» с фото собственной персоны, на запрос «Багамы» машина выдаст как раз ваши радостные ухмылки. Очевидно, при популярности ресурса.

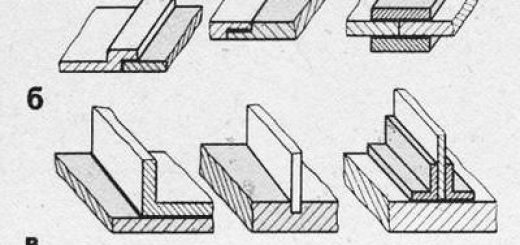

В самом несложном собственном варианте визуальный анализ подразумевает анализ яркостей и совпадения цветов участков двух изображений. В более продвинутом – сопоставление соответствующих точек.

На данном примере видно, как все вариации на тему «Джоконды» программа сравнивает с оригиналом и между собой (иллюстрация Yushi Jing, Shumeet Baluja).

Принимаются во названия и внимание графических файлов (к примеру «Я_на_Багамах.jpg»), и ряд других параметров. Но «картина» практически во всех случаях никак не учитывается – через чур непростая задача.

Кроме того в рамках заданных понятийных категорий (другими словами программа знает, что нужно искать самолёты, к примеру) существующие разработки поиска «похожих» изображений неидеальны.

Громаднейший прогресс в этом направлении достигнут в области фотографий и распознавания лиц – в настройках расширенного поиска «Гугла» либо «Яндекса» такие опции уже предусмотрены. Имеется и специальные ресурсы, трудящиеся с визуальными запросами, как, к примеру, Riya, TinEye либо Picollator.

Все они так или иначе применяют разработку поиска изображений по содержанию – CBIR (Content Based Image Retrieval). Методика эта разрешает оценивать сходство картинок либо фотографий на основании их цвета, текстуры, формы и, реже, вторых параметров.

Загрузив фото Арнольда на Picollator, мы взяли таковой вот комплект лиц. Нет, всё, само собой разумеется, можно понять, но за дам жалко.

По всей видимости, сервис до тех пор пока ещё сыроват (иллюстрация MEMBRANA).

По большей части это реализовано на достаточно скромном уровне. Другими словами сервисы разбирают яркостей и совпадения цветов соответствующих друг другу участков сравниваемых изображений либо, к примеру, обоюдное размещение каждой пары точек объекта.

Как видите, кроме того в лимитированной базе фотографий сервисы трудятся не весьма удачно. Не смотря на то, что теоретически для фото возможно было бы создать совокупность, подобную по собственной точности анализу отпечатков пальцев.

Но для поисковика с неограниченным числом индексируемых изображений это будет через чур дорого. А самое основное – продолжительно: результатов выдачи в течение нескольких (в лучшем случае) мин. не многие пользователи готовы ждать.

Ещё одним а также более фундаментальным ограничением есть сложность механизма зрительного восприятия человека. Главная неприятность тут – разрыв восприятия либо так называемый семантический разрыв.

Сервис TeenEye предлагает отыскать похожие фото и изображения довольно указанного примера. На деле на протяжении серии загрузок портретов знаменитостей мы приобретали одинаковые фото, отличающиеся только по размерности, чёткости и яркости, – иногда на 20 страницах (иллюстрация MEMBRANA).

В случае если перевести на простой язык, это указывает, что не всегда вероятно сознательно сформулировать «верный» текстовый запрос – по крайней мере, в случае если речь заходит о поиске. Один пользователь, вводя слово «солнце», ожидает заметить звезду в окружении планет, а второй – лужайку, голубое небо и много-много света.

Но в данной сложности и кроется большой потенциал. Лишь представьте: вы лишь поразмыслили о чём-то, появился в голове какой-то образ, мелькнула неясная идея – и вы ищите соответствующую картину. А уж дальше приобретаете нужную информацию.

Но, «желаемое» изображение, кроме того не абстрактное, а в полной мере конкретное, – также совсем хорошо.

Сейчас работу в этом направлении деятельно ведут и гиганты наподобие Google, и свободные разработчики. Так, к примеру, несколько учёных из университета Пенсильвании (Pennsylvania State University) заявила о регистрации патента на «семантическую» совокупность визуального поиска ALIPR (Automatic Linguistic Indexing of Pictures in Real-Time).

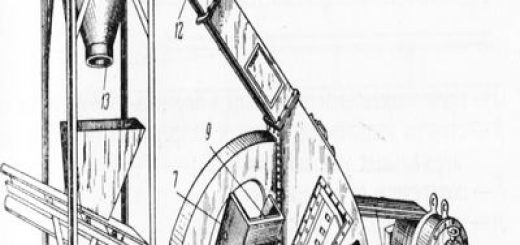

Движок ALIPR разбивает картины на пространственные точки и сравнивает их между собой (иллюстрация Jia Li, James Z. Wang).

Сущность нового сервиса, что в собственном начальном урезанном виде показался ещё в конце 2006 года, в объединении «пиксельного» и смыслового анализа изображений.

В базе ALIPR находится свыше миллиона изображений, к каждому из которых проставлены теги – несколько смысловых «ключей». Главная мысль в том, что восприятие тех либо иных объектов у пользователей Интернета однако подчиняется законам обычного распределения, и, следовательно, самые популярные связки «понятие – объект» должны совпасть с ожиданиями.

На данный момент совокупность оперирует 332 понятиями, но это не свидетельствует, что отыскать возможно картины только по столь ограниченному комплекту слов. При помощи умного метода, в базе которого лежит а также вероятностный лингвистический анализ, большая часть английских терминов, введённых в строчок поиска, находит «собственное» изображение. Но «шкала значений», само собой разумеется, имеет ограничения: на такое слово, как «хромосома» (chromosome), ALIPR по большому счету никак не реагирует.

Возможно, по причине того, что сервис сейчас находится в стадии «самообучения». Авторы проекта деятельно предлагают всем желающим загружать картины – или с твёрдого диска, или скопировав URL. Проанализировав изображение (на это уходит на доли секунды больше в сравнении с простым текстовым запросом), совокупность присваивает каждому файлу 15 тегов и требует наряду с этим оценить их релевантность.

Либо собственный, новый «ключ» проставить.

Пример выдачи по запросу «Эйнштейн». Если вы вправду искали фото великого физика, разумнее обратиться к простым поисковикам.

Более детально с техническими подробностями визуального анализа возможно ознакомиться на личной странице Цзя Ли (Jia Li) – ведущего разработчика проекта (иллюстрация MEMBRANA).

Результаты пока не очень впечатляют. Но, по уверениям разработчиков, в 90% случаев хотя бы одно понятие сходится с «мейнстримовым» восприятием у добровольцев, участвовавших в предварительных тестах.

«Кроме того по одному смысловому критерию результаты ни при каких обстоятельствах не будут полными», — признаёт Цзя Ли. Но, исходя из архитектуры ALIPR, кроме того такие скромные возможности имеют какой-то суть: выдача генерирует последовательность картин, за каждой из которых «прячутся» похожие по смыслу образы. На взгляд машины и тех пользователей, каковые ранее присвоили им обобщающие понятия, очевидно.

Кстати, единственное условие авторов при загрузке изображения – «вкус». Корректировать смысловые теги, по-видимому, столь же бессмысленно, сколь довольно глупо ожидать однообразного восприятия пейзажа за окном либо нового iPhone.

Но возможно, оказывается, пойти и вторым путём. К примеру, по большому счету обойтись без участия субъективных семантических категорий. Правильнее говоря, инженеры из компании Гугл уверены в том, что они, категории эти, ничем по солидному счёту не отличаются от тех смыслов, каковые пользователи вкладывали в изображение, помещая его в собственном блоге либо на сайте.

И каковые находятся при помощи простого поиска.

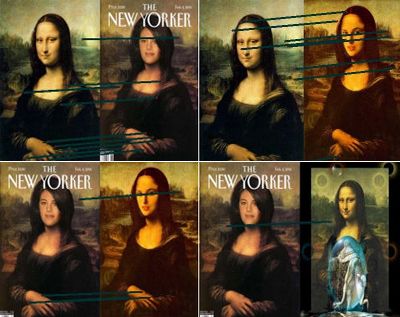

Прототип совокупности VisualRank индексирует прежде всего не только самые релевантные, но и лучшие по размеру и качеству изображения (иллюстрация Yushi Jing, Shumeet Baluja).

Ещё в апреле 2008 года наибольший в мире поисковик разместил на своём блоге данные о первых итогах в области разработки прототипа совокупности VisualRank. Учитывая свободы и возможности, каковые, по слухам, предоставляет Google своим сотрудникам, не совсем ясно, как эта разработка есть стратегическим приоритетом, но блог помой-му официальный.

Cотрудник компании Шумит Балуя (Shumeet Baluja) и Юси Цзинь (Yushi Jing) из технологического университета Джорджии внесли предложение следующее ответ: возможно улучшить результаты выдачи, применяя уже существующую совокупность оценки популярности страниц.

Речь заходит о пара другом принципе совмещения визуального и контекстуального анализа в сравнении с «семантическим». В целом мысль такова: для того чтобы получить самые релевантные ссылки, необходимо графически сравнить индексируемые картины с самыми популярными изображениями по теме, по возможности сгруппировав их в какие-то более неспециализированные категории.

Вверху – уникальный поиск разработчиков VisualRank, внизу – отечественный поиск по подобному запросу macdonalds. Нельзя исключать, что именно на базе схемы, предложенной в VisualRank, Гугл добавил дополнительные смысловые категории (выделено синим).

Да и в целом результаты за каких-то полгода стали более предсказуемыми (иллюстрация Yushi Jing, Shumeet Baluja/MEMBRANA).

Авторы работы приводят как пример запрос по слову McDonalds. Если вы попытаетесь совершить подобное упражнение, то вам наровне со ветхим хорошим М-образным логотипом поиск выдаст достаточно необычные результаты.

Картинки нужно ранжировать по какому-то критерию. Но дело в том, что критерий данный заблаговременно малоизвестен. Кроме того в случае если последовательно «сравнить пиксели» двух изображений на предмет наличия стилизованной буквы «М», не факт, что большая часть пользователей не будет искать наряду с этим Рональда Макдоналда.

Эту проблему исследователи решили, совместив визуальные совпадения со смысловым индексированием. Оказалось что-то наподобие «прогнозируемого поведения пользователей»: поиск самые репрезентативных текстовых маркеров сопровождался отбором графических «обобщений» – по уже известной нам технологии CBIR. Но, конечно, со собственными тонкостями – подробности вы имеете возможность отыскать тут (PDF-документ).

Запрос «картинки Моне», обработанный по новому методу, собирает, с одной стороны, самые популярные и лучшие по качеству репродукции самого Моне, а с другой –узнаваемые портреты Моне работы Ренуара (иллюстрация Yushi Jing, Shumeet Baluja).

«Полевые опробования» на 150 сотрудниках Гугл продемонстрировали, что выдачи VisualRank отображали на 83% меньше нерелевантных картин. Действительно, не по всем запросам такая закономерность соблюдалась – 70 из 272 были более успешными для простого Гугл image search.

Кстати, по состоянию на начало мая этого года разработка, по заявлению разработчиков, ещё не была «живой». Но, в полной мере быть может, гигант поиска уже применял последовательность ответов на практике.

Кроме уже упомянутых дополнительных категорий, как при с «Макдоналдсом», это возможность сортировки выдачи по фотографиям – опция по-негромкому показалась только в первых числах Октября и, Наверное, стоит ожидать предстоящих апгрейдов популярного поисковика.

В общем, интернет-поиск – это та область, где прогресс в буквальном смысле не следует на месте.

В полной мере быть может, что в скором времени возможно будет совсем нормально отрефлексировать собственный архетип, отыскав единомышленников по картинам из сновидений, либо обучиться наконец без неприятностей обнаружить «то-не-знаю-что».