Ударим по рукам: интерфейс skinput извлекает данные из кожи вон

Пилотную версию новой совокупности ввода информации Skinput, располагающуюся конкретно на руке человека, показали американские инженеры. Наименование новинки образовано от двух слов skin и input, что возможно перевести как ввод/управление при помощи кожи. Неизменно дешёвый экран для собственной работы применяет биоакустические параметры людской тела, но наряду с этим не делает пользователей киборгами.

Устройство разрешает руководить разными приложениями при помощи простого нажатия на кожу руки в области предплечья, ладони либо пальцев. И никакой тебе встроенной электроники!

Вся думающая начинка сосредоточена в «браслете», охватывающем руку человека чуть выше локтя. В том месте же расположен миниатюрный проектор, что выводит на предплечье либо ладонь изображение виртуальной клавиатуры, меню либо каждый графический объект.

Браслет дополнительно оборудовали маленьким проектором, что демонстрирует отклик главного устройства на прикосновения (фото Harrison et al.).

В «браслета» находятся датчики, ориентирующиеся на звуковые (механические) вибрации и низкочастотные сигналы, каковые, как мы знаем, распространяются по руке при прикосновении к любой её части либо похлопывании по ней.

Чувствительные элементы определяют, на какую «кнопку» на виртуальном дисплее только что надавил пользователь. Потом по беспроводной связи сигнал передаётся контролируемому устройству: телефону, MP3-плееру либо кроме того компьютеру.

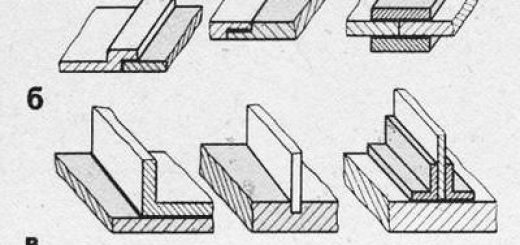

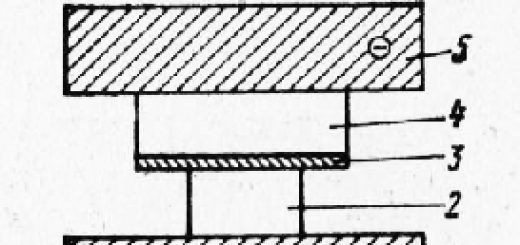

«Браслет», больше похожий на нашивку либо нарукавную повязку, оборудован закреплёнными только с одного финиша пьезоэлектрическими плёнками. Их по пять в каждой из двух коробочек (продемонстрированы на нижнем фото). Любая составляющая «настроена» на собственную частоту.

Комбинация показателей разрешает выяснить правильное расположение похлопывания (фото Harrison et al.).

Крису Харрисону (Chris Harrison) из университета Карнеги-Меллона, известному нам по созданию тактильного экрана с подвижными кнопками, и Деснею Тану (Desney Tan) и Дэну Моррису (Dan Morris) из исследовательского подразделения Микрософт Research удалось вынудить электронику определять правильное место прикосновения.

Помогли им в этом различия в плотности, массе и размерах костей, суставов, кожи и мышц. Из-за всех этих параметров каждое место прикосновения, а правильнее лёгкого похлопывания пальцами, издаёт собственный неповторимый звук. Чувствительности датчиков хватает чтобы «развести» на руке пять областей с точностью в 95,5%.

Согласно точки зрения авторов разработки, этого хватит для большинства мобильных устройств.

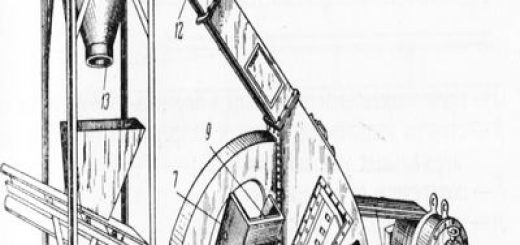

Тут продемонстрированы две схемы дорог, которыми сенсоры смогут ощутить похлопывание пальцем. Вверху – отклик, передаваемый мышцами и кожей, внизу – костью (иллюстрация Chris Harrison et al.).

На сайте проекта в видеороликах возможно заметить, как американцы при помощи «кликов» по коже играются в игры, к примеру в тетрис, руководят аудиоплеером и телефоном, реализовывают навигацию по пунктам меню. Новинку опробовали на себе и 20 добровольцев. Все они признали, что трудиться со «Скинпутом» легко кроме того на ходу либо на протяжении пробежки.

удобство и Уникальность применения авторы новинки растолковывают так: рука — громадной сенсорный экран, что у нас неизменно при себе. С нынешней тенденцией к одновременному уменьшению и усложнению размеров мобильных гаджетов всё проблематичнее руководить ими. Разные кнопки, колёса прокрутки и дисплеи становятся через чур миниатюрными.

«Клик» по ладони и по предплечью для Skinput – две совсем различные команды (фото и иллюстрация Harrison et al.).

Как раз исходя из этого американцы предлагают другой вариант решения проблемы: применение для этих целей самой мобильной (из имеющихся в наличии) поверхности людской тела.

В её пользу говорит не только громадная площадь, но и постоянная доступность (кстати, не только рук, но и верхней части ног и туловища). Имеется и ещё одно преимущество: так называемая проприорецепция, либо чувство положения частей собственного тела относительно друг друга и в пространстве.

Именно поэтому эмоции человек может свободно хлопнуть в ладоши, щёлкнуть пальцами, дотронуться до кончика носа, не устремляя на эти части тела собственный взор. А ведь все эти жесты смогут быть использованы для управления каким-либо устройством. Так из-за чего бы этим не воспользоваться?

Тан кроме этого принимал участие в создании игровой приставки Project Natal и интерфейса Микрософт Surface, существенно расширяющих простые возможности компьютера и взаимодействия человека (фото Микрософт Research).

Другие разработчики не преминули подчернуть, что, не обращая внимания на оригинальность идеи, имеется у новинки и собственные недочёты. Так, Пранав Мистри (Pranav Mistry) из медиалаборатории Массачусетского технологического университета уверен в том, что при надевании «браслета» пользователям будет необходимо его весьма точно не только настраивать под себя, но и просто располагать на руке. Это нужно, дабы проектор верно позиционировал изображение.

Весьма интересно было бы кроме этого определить, как довольно часто прибору будет требоваться подстройка под себя. Так как не считая более-менее постоянных параметров руки остаются другие сопутствующие факторы. Как будет реагировать устройство, в случае если окружающая среда будет «загрязнена» низкочастотными звуками?

На дискотеке либо на стройплощадке, к примеру.

А что изменится, в случае если рука будет не в стандартном положении (согнута не на 90°, скручена)? А вдруг пользователь только что вышел из тренажёрного зала, где в течение пары часов качал мускулатуру? Ответы возможно будет взять, лишь опробовав настоящий продукт.

Имеется вопросы и к применению «Скинпута» в качестве клавиатуры для телефона (эта мысль уж весьма по душе разработчикам устройства). Дабы не извлекать мобильный из кармана либо сумки, будет необходимо кроме этого использовать Bluetooth-гарнитуру. Но, в случае если посмотреть в будущее, то в том месте с этим неприятностей точно меньше: микрофон будет размешаться в зубе, а наушник или за ухом, или прямо в черепе.

Однако Skinput может занять собственную нишу на рынке: он понадобится в том месте, где некомфортно трудиться с простыми устройствами ввода. К примеру, в виртуальных играх, в то время, когда на голове шлем. (Кто заявил, что в этом случае в обязательном порядке применять куда более сложную совокупность управления жестами?)

Сейчас Тан параллельно занимается разработкой интерфейса Natural User Interfaces with Physiological Sensing, что «ощущает» сокращения мышц. Он и коллеги сравнительно не так давно представили её на фестивале TechFest 2010.

На снимке Десней демонстрирует NUI в действии (фото Микрософт Research on Flickr/flickr.com и Микрософт Research).

Больше подробностей о работе новинки и её датчиков возможно определить из статьи (смотрите PDF-документ). Кстати, совокупность Skinput будет кроме этого показана на интернациональной конференции CHI 2010, которая пройдёт с 5 по 15 апреля в Атланте. В том месте все желающие смогут оценить её удобство и составить собственное собственное вывод о будущем «Скинпута» как серийного продукта.